Чтобы поисковые системы правильно индексировали ваш блог, достаточно правильно составить файл Robots txt для WordPress. Разберемся, как правильно создать, что в нем прописать и как установить.

Для чего нужен и где лежит Роботс

Предназначен для поисковиков и их роботов, для правильного индексирования страниц сайта. Директивы в содержимом файла четко указывают, какой контент нужно показывать в поиске.

Этот инструмент позволит выдавать Googl’ом или Яндексом только полезное содержимое ресурса.

Файл Robots.txt располагается в корневом каталоге сайта. Его содержимое должно быть доступно по адресу

https://site.ru/robots.txtНе могу найти Robots.txt

Если по указанному выше URL-адресу содержимое файла доступно, но физически его нет в корневой папке веб-ресурса, то значит он создан виртуально. Это не ошибка, а возможность движка ВордПресс.

Директивы robots.txt

- User-agent — правила для поисковых роботов.

- Disalow — запрет индексирования.

- Allow — разрешение.

- Sitemap — путь к XML-карте.

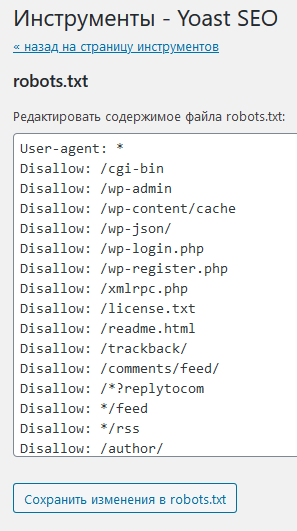

Пример Роботс для ВордПресс

Для каждого сайта содержимое файла отличается.

Вот список директив для типичного WP-сайта.

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-content/cache

Disallow: /wp-json/

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /license.txt

Disallow: /readme.html

Disallow: /trackback/

Disallow: /comments/feed/

Disallow: /*?replytocom

Disallow: */feed

Disallow: */rss

Disallow: /author/

Disallow: /?

Disallow: /*?

Disallow: /?s=

Disallow: *&s=

Disallow: /search

Disallow: *?attachment_id=

Allow: /*.css

Allow: /*.js

Allow: /wp-content/uploads/

Allow: /wp-content/themes/

Allow: /wp-content/plugins/

Sitemap: https://site.ru/sitemap_index.xmlВ первой строке говорится, что содержимое сайта могут обходить все поисковые роботы.

Строки с Disallow запрещают индексировать:

- ленты RSS (Feed);

- страницы авторов, поиска и вложений;

- служебные папки и файлы;

- кэш;

- страницы входа в систему и регистрации.

С Allow роботам доступны:

- скрипты и стили;

- файлы загрузок, тем и плагинов.

Последняя строка – путь к XML-карте со списком полезного содержимого.

Как создать правильный robots.txt

Разберем несколько способов.

Вручную

Метод сводится до создания обычного текстового файла: в любом текстовом редакторе на локальном сервере или с помощью FTP-клиента на сервере хостинга.

Через ВП-плагины

Разберем лучшие из них.

Clearfy Pro

Это премиум-решение, которое создает виртуальный файл Роботс. Для этого

- Перейдите в раздел Clearfy Pro.

- Откройте вкладку SEO.

- Задействуйте Создать правильный robots.txt.

- Впишите директивы.

- Сохраните изменения.

Если нужно изменить содержимое, откройте эту опцию еще раз и сохраните.

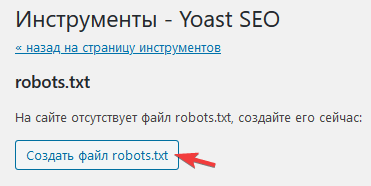

Yoast SEO

Этот СЕО-модуль для WP также справится с задачей.

1. Перейдите SEO > Инструменты.

2. Нажмите Редактор файлов.

3. Если этот файл в корневой папке отсутствует, нажмите Создать файл robots.txt.

4. Если он есть, то откроется редактор.

5. Если изменили содержимое, кликните по кнопке ниже.

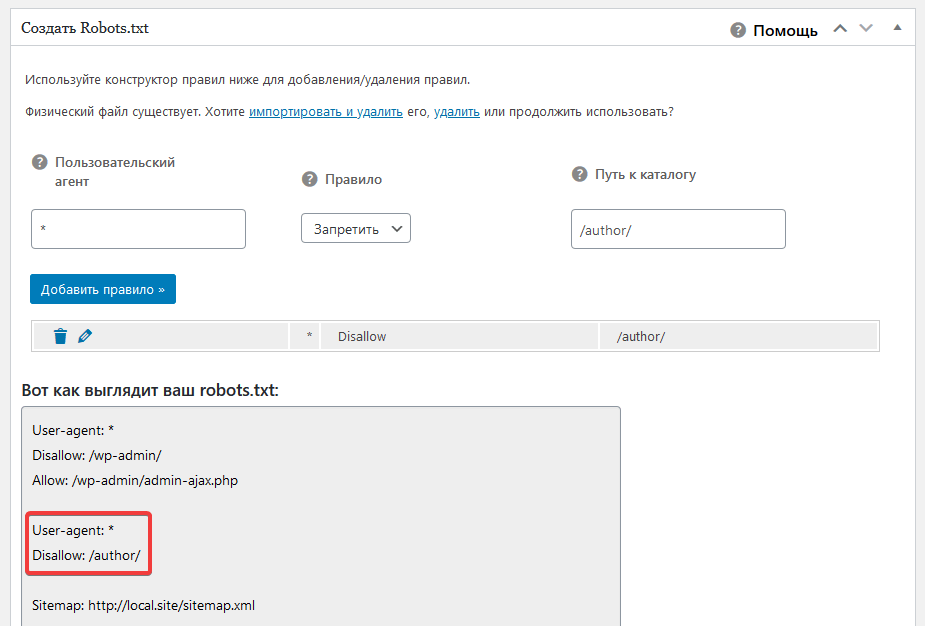

All in One SEO Pack

Еще один бесплатный SEO-инструмент, который тоже отлично решит задачу.

1. В админке откройте All in One SEO > Модули.

2. Из списка выберите одноименное название модуля и кликните Activate.

3. Перейдите All in One SEO > Robots.txt.

4. В полях укажите нужные директивы.

Настройка Robots.txt для интернет-магазинов на основе WooCommerce

Для этого расширения тоже есть свои директивы.

Disallow: /cart/

Disallow: /checkout/

Disallow: /*add-to-cart=*

Disallow: /my-account/